Développer son assistant vocal, c’est possible oui !

Comme pour l’iPhone en 2007 qui sera le précurseur de l’avènement des smartphones, les assistants vocaux sont en train de bouleverser le quotidien de millions de personnes.

Petit appareil discret qui se faufile dans nos salons, il séduit rapidement par sa facilité d’utilisation. En effet, avec une simple commande vocale, il devient facile de commander ou de demander des informations à son assistant.

La voix étant un médium de communication naturel chez l’être humain cela rend cette technologie facile d’accès même pour les non-technophiles.

Ainsi, depuis de nombreuses années, nous avons vu apparaître de multiples acteurs sur ce marché: Google, Apple, Amazon. Tous essaient de tirer parti de ces assistants pour apporter et capter de la valeur à leurs clients.

Entre les enceintes connectées et les smartphones, il est facile de faire appel à son assistant vocal, mais comment s’y retrouver avec tous ces assistants disponibles sur le marché ? Comment rendre mon objet connecté compatible ? Dois-je faire confiance et accepter de donner mes données au grand de ce monde ?

Toutes ces interrogations doivent permettre de vous guider dans la conception de votre objet connecté.

Pour décortiquer et comprendre l’univers des assistants vocaux, nous vous proposons ici quelques pistes pour vous guider.

Comment fonctionne un assistant vocal ?

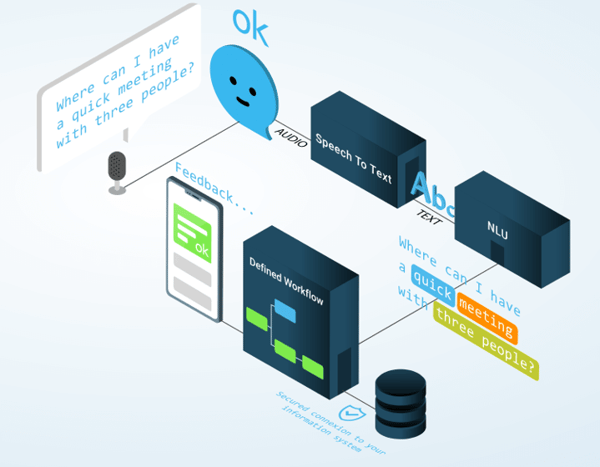

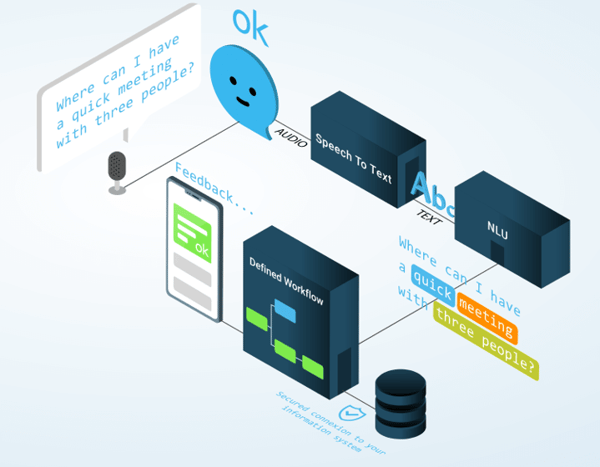

Pour bien comprendre les tenants et les aboutissants, il est important de connaître les principes fondamentaux qui composent un assistant vocal. Pour ce faire, nous allons diviser ce fonctionnement en 4 grandes étapes :

1. La captation de la voix

Vous l’aurez compris, l’assistant vocal passe par la voix, c’est la première étape du processus. Cette phase est très importante, car la compréhension de votre assistant vocal dépendra avant tout de la qualité audio qu’il reçoit. Aujourd’hui, le cas le plus fréquent est de passer par son enceinte connectée ou son smartphone, deux produits conçus spécialement autour de la voix. Ainsi, si demain votre produit doit lui aussi être capable d’écouter et d’enregistrer de la voix, il faudra que votre chaîne audio soit parfaitement maîtrisée. Pour activer son assistant vocal, l’utilisation de mot-clé est nécessaire par exemple, “OK Google”, “Dis Siri”. C’est cette activation qui permet ensuite d’atteindre notre seconde étape, l’analyse de flux audio.

Vous l’aurez compris, l’assistant vocal passe par la voix, c’est la première étape du processus. Cette phase est très importante, car la compréhension de votre assistant vocal dépendra avant tout de la qualité audio qu’il reçoit. Aujourd’hui, le cas le plus fréquent est de passer par son enceinte connectée ou son smartphone, deux produits conçus spécialement autour de la voix. Ainsi, si demain votre produit doit lui aussi être capable d’écouter et d’enregistrer de la voix, il faudra que votre chaîne audio soit parfaitement maîtrisée. Pour activer son assistant vocal, l’utilisation de mot-clé est nécessaire par exemple, “OK Google”, “Dis Siri”. C’est cette activation qui permet ensuite d’atteindre notre seconde étape, l’analyse de flux audio.

2. Transformation de l’audio en texte

“Text to speech” en anglais, cette étape transforme l’audio enregistré en texte. En effet, l’audio est décomposé sous forme de texte ce qui permet une analyse plus poussée.

“Text to speech” en anglais, cette étape transforme l’audio enregistré en texte. En effet, l’audio est décomposé sous forme de texte ce qui permet une analyse plus poussée.

3. Natural Language Understanding (NLU)

La brique NLU permet d’analyser et décrypter les messages textes entrants pour en définir un sens et en extraire des informations structurées qu’une machine peut comprendre et analyser. Le NLU produit une ou plusieurs analyses sémantiques basées sur le sens des mots puis un annotateur de confiance identifie la meilleure analyse.

La brique NLU permet d’analyser et décrypter les messages textes entrants pour en définir un sens et en extraire des informations structurées qu’une machine peut comprendre et analyser. Le NLU produit une ou plusieurs analyses sémantiques basées sur le sens des mots puis un annotateur de confiance identifie la meilleure analyse.

4. L’application métier

Grâce à la structuration qu’apporte le NLU, nous pouvons ensuite développer une application métier qui va réagir au différent entrant.

Grâce à la structuration qu’apporte le NLU, nous pouvons ensuite développer une application métier qui va réagir au différent entrant.

Prenons l’exemple suivant : « Montre-moi les vols Lyon Paris pour le 6 février. »

L’application métier par l’intermédiaire du NLU va recevoir des messages structurés de la forme suivante.

- Domaine : vol

- Intention : Montre-moi

- Entité 1 ville de départ : Lyon

- Entité 2 ville d’arrivée : Paris

- Entité 3 date : 06/02/2020

Cette structuration permet ainsi au développeur de comprendre les besoins de l’utilisateur et de gérer des actions en conséquence.

Voici un schématique succinct qui rappel nos différentes étapes.

Source: https://linto.ai/fr/

Tous les assistants vocaux sont principalement basés sur ce type de fonctionnement. Mais nous allons voir qu’en fonction des différents acteurs, tout n’est pas forcément accessible ou en libre accès. Si les bases sont communes, il n’est pas toujours évident de s’y retrouver, car les méthodes de développement ne sont pas les mêmes.

Les plateformes pour développer son assistant vocal ?

Les deux principaux acteurs dans le monde des assistants sont Google et Amazon. Tous deux proposent des enceintes connectées à prix cassé pour envahir votre quotidien.

Leurs offres sont uniquement basées sur le Cloud, c’est-à-dire que les objets avec une interface vocale doivent impérativement être connectés à Internet pour fonctionner. En effet, comme vu précédemment toutes les parties Speech to Text, NLU et application métier sont déportés dans le cloud. Cela permet ainsi de fournir des assistants vocaux extrêmement performants. Le fait d’être entièrement dans le Cloud permet aux assistants d’interroger directement d’autres serveurs et Internet pour être les plus pertinents possible. Google et Amazon fournissent un certain nombre d’API pour pouvoir s’interfacer facilement avec les assistants.

Ainsi, les plateformes apparaissent comme deux boîtes noires capables de décoder la voix et fournir aux développeurs les actions associées. Pour simplifier le process, Google et Amazon demandent simplement aux développeurs d’ajouter la compétence à leurs assistants pour pouvoir manipuler un objet. Chez Amazon, il s’agit de développer des Skills, c’est-à-dire que le développeur doit apprendre une nouvelle compétence à Alexa pour interagir avec un objet. C’est le même fonctionnement chez Google avec le terme Action.

Le fait que tout soit dans le Cloud donne une grande puissance à ces acteurs, car ce sont toujours plus de données qui sont récupérées pour analyser nos comportements. Ainsi, des conseils concernant la vie privée des utilisateurs font régulièrement surface (enceinte qui écoute en permanence, employé qui écoute, etc.). Cependant, leurs simplicités d’utilisations, leur omniprésence et leurs impacts marketing en font souvent un choix incontournable.

Il existe néanmoins quelques alternatives plus respectueuses de la vie privée, parfois open source, et qui dans certains cas fonctionne sans connexion Internet. En fonction de vos contraintes projets, du degré de vie privée et de sécurité exigée, le choix d’un assistant customisé pour votre objet peut paraître essentiel.

>> Lire l’article sur les comparatifs de plateformes IoT

Dans ce cas, il est nécessaire de se faire accompagner et chez Rtone nous avons déjà réalisé des solutions de ce type, notamment avec la plateforme Snips récemment rachetée par Sonos pour justement s’abstraire le plus possible des GAFA.

Voici une liste (non-exhaustives) des plateformes intéressantes dans le vocal :

Peu importe l’assistant : pourquoi se faire accompagner pour développer son assistant vocal est une bonne idée ?

Si la voix semble facile et naturelle à l’être humain, elle génère quelques difficultés dans le développement d’une application. Prenons l’exemple basique du besoin d’éteindre une lumière. Dans le monde physique ou sur une application mobile, l’interface utilisateur proposée sera un bouton. Ainsi, dans son expérience, l’utilisateur appuiera ou non sur un bouton, il s’agit d’un simple choix binaire très facile à interpréter.

Prenons maintenant le même besoin de commander cette lumière, mais par la voix. En fonction de l’utilisateur, la façon de demander peut être différente et l’assistant doit pouvoir le comprendre et l’interpréter. Ainsi, nous pourrions avoir les messages suivants: “Éteins la lumière”, “Coupe-moi la lumière”, “Je veux qu’il fasse tout noir”, “Mets le mode nuit”, etc. On se rend vite compte que même avec un cas simple, l’expérience peut devenir compliquée. Ajoutons à cela le contexte et la position. Si par exemple votre interrupteur est fixe et correspond toujours à l’interrupteur de la cuisine comment faire comprendre à votre assistant quelle lumière éteindre ? Pas toujours simple.

Aujourd’hui, les assistants vocaux et leurs fonctionnalités se développent rapidement. De nombreux assistants sont capables maintenant de reconnaître des voix, de vous situer dans l’espace (avec plusieurs assistants en multiroom), de faire des achats à votre place. L’expérience utilisateur s’enrichit et devient de plus en plus complexe. C’est pourquoi il nous semble essentiel quelle que soit la plateforme choisie de se faire accompagner.

Conclusion

Avant de vous lancer et développer votre propre assistant vocal, il est nécessaire de se poser un certain nombre de questions :

- Quel va être le ROI ?

- Comment pouvons-nous être présents sur le vocal avec une expérience ‘wahou’ ?

- Comment savoir ce qui est possible en vocal pour mon entreprise ?

- Quelle solution technique choisir parmi la pléthore de plateformes ?

Toutes ces questions sont légitimes. Le vocal, d’apparence accessible, peut se révéler d’une grande complexité pouvant mener l’utilisateur à de mauvaises expériences.

Rtone, expert des objets connectés, à très vite compris l’intérêt du vocal et l’interaction qu’il apporte aujourd’hui avec les objets.

C’est pourquoi nous vous accompagnons autour de workshop et développons avec vous, votre expérience vocale de demain.

Vous souhaitez développer votre propre assistant vocal ? Recevez un accompagnement sur-mesure en contactant nos experts.

Grâce à la structuration qu’apporte le NLU, nous pouvons ensuite développer une application métier qui va réagir au différent entrant.

Grâce à la structuration qu’apporte le NLU, nous pouvons ensuite développer une application métier qui va réagir au différent entrant.